生成AIの急速な進歩により、様々な業務をAIに任せられるようになった一方で、使用制限やコストの問題に直面する機会も増えています。特に日本語でAIを活用する際には、英語と比較してトークン消費量が多くなるという課題があります。本コラムでは、筆者が実際にClaude Proを使用する中で得た知見をもとに、生成AIのコストを抑えながら効率的に活用するための具体的なテクニックをご紹介します。

記事のポイント

- 日本語は英語よりもトークン消費量が多く、コストが高くなりがち

- ドキュメント作成方針の工夫で使用制限の回避が可能

- 半角・全角の使い分けだけでも大幅なコスト削減効果がある

- 小さな工夫の積み重ねが大きなコスト削減につながる

目次

AIの進歩と業務拡大の現状

相変わらず、最近のAIの進歩は目を見張るものがあります。AIの機能が向上し、パフォーマンスが上がっていくにつれて、AIに任せられる業務の範囲がどんどん広がっています。

筆者の場合、システム開発からドキュメント作成、プロジェクト管理まで、様々な業務でAIを活用していますが、その恩恵は計り知れません。しかし、同時に新たな課題も浮上してきました。それは「使用制限」と「コスト」の問題です。

AI使用制限という現実的な壁

筆者は現在Claude Pro(月額20ドル)を使用しており、ClaudeのデスクトップアプリでClaude Codeを使ってシステム開発を行っています。コードを書いて保存したり、プロジェクト管理のドキュメントの更新などをClaude Codeに任せていると、あっという間に使用制限に到達してしまいます。

Claudeの使用制限は5時間でリセットされるのですが、筆者の場合は2時間ほどで制限に達してしまい、残りの3時間は別の作業をするか休憩せざるを得ません。特に困るのは、作業が一番ノってきたときに使用制限が来てしまうことです。

この問題をなんとか解決したいと考え、様々な工夫を試みました。

ドキュメント作成方針でコスト削減を実現

試行錯誤の結果、筆者(とClaude)が作り上げたドキュメント作成方針の一部をご紹介します。以下のテンプレートは、そのままコピーしてご活用いただけます:

ドキュメント作成方針テンプレート

## 基本方針

### 目標

- **Claude利用制限の回避**: やり取り回数・文字数の最小化

- **効率的な情報管理**: 必要な情報への素早いアクセス

- **スケーラブルな構造**: プロジェクト拡大に対応

- **再利用性の確保**: 他プロジェクトでの活用

### 設計原則

- **分割統治**: 大きなファイルは機能別・更新頻度別に分割

- **単一責任**: 1ファイル1目的の明確化

- **階層化**: 詳細度に応じた情報の構造化

- **最小依存**: ファイル間の相互依存を最小化

---

## ファイルサイズガイドライン

### 推奨サイズ

| ファイル種類 | 推奨行数 | 最大行数 | 理由 |

|-------------|----------|----------|------|

| **基本情報系** | 50-80行 | 100行 | 更新頻度低・安定性重視 |

| **技術仕様系** | 80-120行 | 150行 | 詳細情報必要・中頻度更新 |

| **進捗管理系** | 60-100行 | 120行 | 高頻度更新・簡潔性重視 |

| **分析・レポート系** | 80-120行 | 150行 | 包括的情報・低頻度更新 |

| **作業ログ系** | 100-200行 | 300行 | 詳細記録・アーカイブ性重視 |

### サイズ制御テクニック

【圧縮技術】

- 表形式の活用(箇条書きより効率的)

- 階層化見出し(## ### ####)

- 略語・記号の統一使用

- 冗長な表現の排除

【分割基準】

- 機能別分割: 技術・事業・管理

- 時系列分割: 過去・現在・未来

- 重要度分割: 重要・通常・参考

- 更新頻度分割: 高・中・低

これが最適解だとは思いませんし、この方針通りにすべてを整えられるわけではありません。しかし、これをAIに指示しておくことで、筆者の場合は体感で15~20分ほど作業できる時間が伸びました。よろしければ参考にしてください。

トークンの仕組み:英語と日本語の決定的な違い

現時点の言語生成AIにおいて、定額プランでできないことを実行しようとすると、トークン数による従量課金が必要になります。ここで重要なのは、トークン数が言語によって大きく異なることです。

基本的なトークン数の違い

- 英語の場合: 1単語≒1トークン(例外あり)

- 日本語の場合: 1文字≒1~3トークンで、文字によって異なる

具体例で見る差

例えば、以下の文章を比較してみましょう:

- 日本語:「私は犬が好きです。」→ 6トークン

- 英語:「I like dogs.」→ 4トークン

同じ意味でも、日本語にするだけで1.5倍のトークンが消費されることになります。この比率は一概ではありませんが、少なくとも英語よりも日本語の方がトークン数は多くなる傾向があります。

全角・半角の影響

また、全角と半角の違いも大きな影響を与えます。半角の英数字を用いるだけでもトークン数は大幅に削減できます。

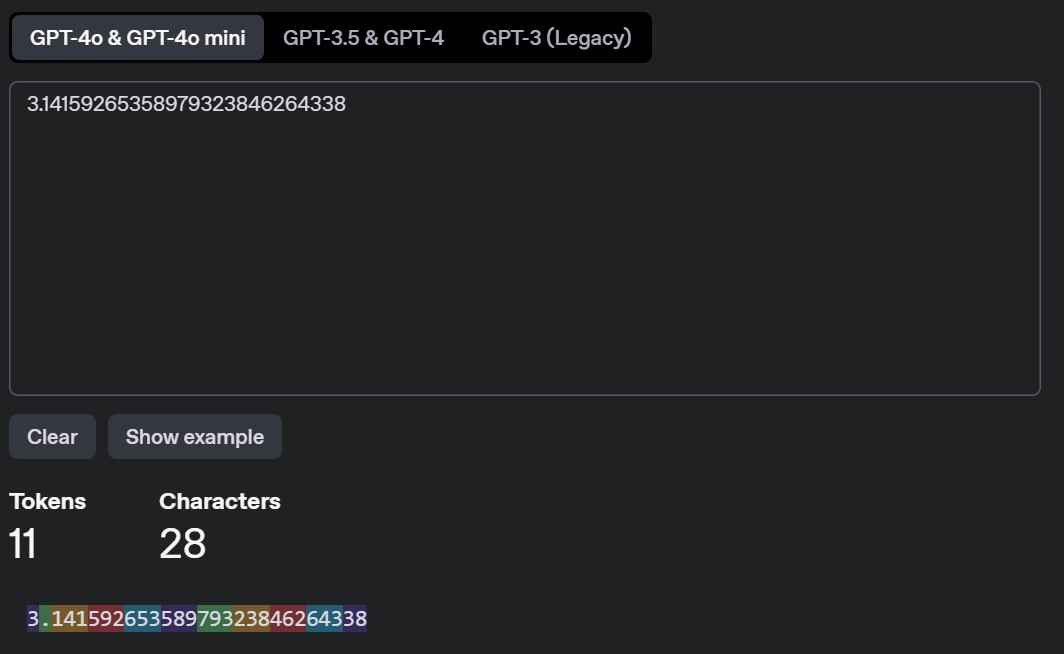

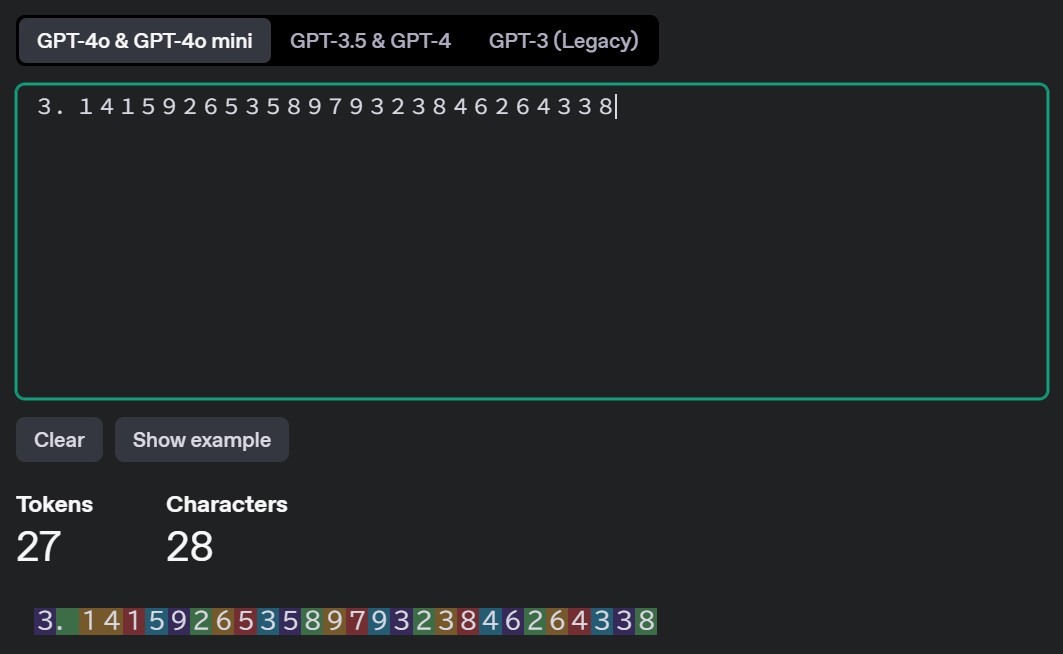

興味深い例として、筆者が記憶している円周率で試したところ:

- 半角表記:11トークン

- 全角表記:27トークン

という結果になりました。

このように、同じ内容でも全角と半角の違いだけで2倍以上のトークン数の差が生まれることが分かります。

トークン数チェックツール

トークン数は、以下のサイトで簡単に調べることができます:

便利ツール

https://platform.openai.com/tokenizer

このトークンの考え方は、コストカットに直結する知識なので、技術者でなくても理解しておくことをお勧めします。

まとめ:小さな工夫が大きなコスト削減につながる

何も考えずに生成AIを使っていると、知らないうちに無駄な費用を支払っていることがあります。しかし、ちょっとした工夫をするだけで、大幅なコスト削減が可能になります。

特に日本語でAIを活用する企業にとって、トークン数の違いを理解することは重要です。ドキュメントの構造化、表記方法の統一、効率的な情報整理など、今回ご紹介したテクニックは、すぐに実践できるものばかりです。

これ以外にも、生成AIを安く使うコツは数多く存在します。当社では、こうした実践的なノウハウを蓄積し、お客様のAI活用をより効率的かつ経済的にサポートしています。AI導入やコスト最適化でお悩みの方は、ぜひお気軽にご相談ください。

次回のコラムでも、さらなるコスト削減テクニックをご紹介予定です。ご期待ください。